Hugging Face Datasets: 'Github' Cho Dữ Liệu Tài Chính Của Bạn

Mục lục

Trong lĩnh vực phân tích chứng khoán và đầu tư định lượng, việc quản lý dữ liệu luôn là một thách thức lớn. Hãy tưởng tượng bạn là một chuyên gia phân tích đang xây dựng một hệ thống giao dịch tự động, hay một nhà đầu tư cần theo dõi hàng trăm mã chứng khoán với dữ liệu được cập nhật liên tục từ nhiều nguồn khác nhau.

Những nỗi đau quen thuộc:

- File CSV chứa dữ liệu phân tích rất thông dụng nhưng ngày càng chiếm nhiều không gian lưu trữ và không tối ưu hiệu năng đọc/ghi khi làm việc với số lượng lớn dữ liệu.

- Muốn chia sẻ bộ dữ liệu thị trường với đội nhóm phân tích? Phải nén lại rồi gửi qua email, Telegram hoặc Google Drive khá bất tiện.

- Dữ liệu từ nhiều nguồn cấp có cấu trúc khác nhau, khó chuẩn hóa và tích hợp.

Nếu bạn đã có kinh nghiệm lập trình Python trong lĩnh vực tài chính, bạn sẽ thấy sự tương phản rõ rệt: chúng ta có Github để quản lý code một cách chuyên nghiệp - phiên bản hóa, chia sẻ, hợp tác nhóm - nhưng dữ liệu tài chính thì sao?

Dữ liệu thường bị đối xử như công dân hạng hai, mặc dù nó là yếu tố quyết định thành công của mọi chiến lược đầu tư. Đây chính là lúc Hugging Face Datasets xuất hiện như một giải pháp hoàn hảo - không chỉ là nơi lưu trữ dữ liệu đào tạo các mô hình AI tiên tiến trên thế giới, mà còn là "Github cho Dữ liệu Tài Chính" miễn phí và chất lượng.

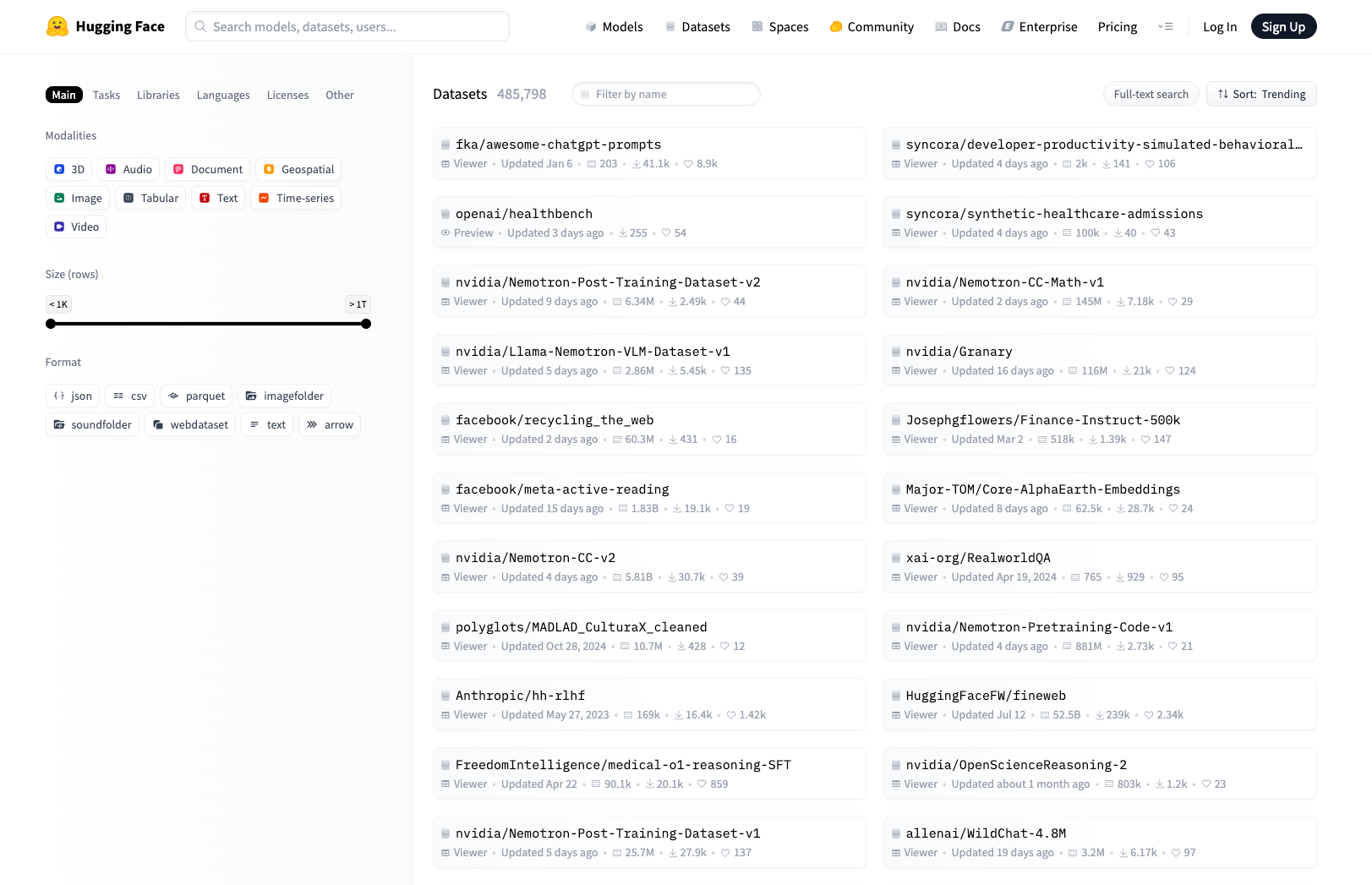

Hugging Face Datasets Là Gì?

Hugging Face Datasets: Giải Pháp Lưu Trữ Dữ Liệu Chuyên Nghiệp

Hugging Face Datasets bao gồm hai thành phần chính hoạt động độc lập nhưng có thể kết hợp với nhau: thư viện Python và dịch vụ lưu trữ đám mây.

Thư viện Python datasets

Đây là thư viện mã nguồn mở sử dụng Apache Arrow, mang lại hiệu suất vượt trội so với pandas truyền thống:

Python# Cách truyền thống với pandas import pandas as pd df = pd.read_csv('stock_data_large.csv') # Chậm với file lớn # Cách hiện đại với datasets from datasets import Dataset dataset = Dataset.from_csv('stock_data_large.csv') # Nhanh hơn đáng kể

Dịch vụ lưu trữ Hugging Face Hub

Nền tảng đám mây cho phép lưu trữ, phiên bản hóa và chia sẻ datasets chuyên nghiệp. Giống như Github cho code, Hub là "Github cho dữ liệu" - miễn phí cho repository công khai, có tùy chọn trả phí cho dữ liệu riêng tư.

Cách hoạt động của Datasets

Hai thành phần này tạo nên một hệ sinh thái hoàn chỉnh:

Python# Tạo dataset từ dữ liệu local from datasets import Dataset import pandas as pd vn30_data = pd.read_csv('vn30_historical.csv') dataset = Dataset.from_pandas(vn30_data) # Push lên Hub để lưu trữ và chia sẻ dataset.push_to_hub("your-huggingface-username/vn30-dataset") # Mọi người có thể tải và sử dụng from datasets import load_dataset shared_dataset = load_dataset("your-huggingface-username/vn30-dataset")

Ưu Điểm Vượt Trội

So với CSV/Excel

| CSV/Excel (Truyền thống) | Datasets (Hiện đại) |

|---|---|

| ✅ Đơn giản, dễ hiểu | ✅ Hiệu suất cao với Apache Arrow |

| ❌ Chậm với file lớn (>100MB) | ✅ Nén tự động (tiết kiệm 60-80% dung lượng) |

| ❌ Khó chia sẻ và quản lý phiên bản | ✅ Streaming data (xử lý file lớn hơn RAM) |

| ❌ Mất metadata và kiểu dữ liệu | ✅ Tích hợp sẵn version control |

So với Database (MySQL, PostgreSQL)

Database mạnh về SQL và truy cập song song, nhưng cần thiết lập phức tạp và khó chia sẻ dataset hoàn chỉnh.

Datasets không cần thiết lập database, dễ chia sẻ và tái tạo dữ liệu, tối ưu cho ML/AI workflows với khả năng streaming và lazy loading. Tuy nhiên không có các truy vấn SQL phức tạp như database truyền thống.

Ứng Dụng Thực Tế: Workflow Hiện Đại

Hãy xem cách Datasets thay đổi quy trình phân tích chứng khoán:

Workflow cũ:

- Script Python trên VPS cào dữ liệu → lưu dạng CSV

- SSH vào VPS, nén file, tải về máy để phân tích

- Chia sẻ qua email/Drive - rất bất tiện

Workflow mới với Datasets:

Trên VPS:

Pythonfrom huggingface_hub import HfApi api = HfApi() # Sau khi thu thập dữ liệu api.upload_file( path_or_fileobj="path/to/data.csv", path_in_repo="data.csv", repo_id="your-username/financial-dataset", repo_type="dataset", commit_message="Daily data update" )

Trên máy phân tích:

Pythonfrom datasets import load_dataset # Tải dữ liệu mới nhất chỉ với 1 dòng dataset = load_dataset("your-huggingface-username/financial-dataset", use_auth_token=True) df = dataset['train'].to_pandas()

Dữ liệu giờ luôn đồng bộ, có lịch sử phiên bản, và sẵn sàng sử dụng ở bất kỳ đâu.

Nhận bài viết mới nhất

Hãy là người đầu tiên nhận những bài viết mới và thông tin bổ ích từ Vnstock.

Những Tính Năng Nổi Bật Khác

- Xử lý dữ liệu lớn hơn RAM: Apache Arrow cho phép xử lý file GB/TB mà không cần tải toàn bộ vào bộ nhớ

- Tích hợp DuckDB: Chạy SQL trực tiếp trên dataset mà không cần tải về

- Chia sẻ và khám phá: Công khai dataset cho cộng đồng hoặc tạo tổ chức (Organization) cho đội nhóm

Bắt Đầu Ngay Hôm Nay

-

Tạo tài khoản: Truy cập huggingface.co

-

Cài đặt thư viện:

Shellpip install datasets huggingface_hub -

Đăng nhập:

Shellhuggingface-cli login -

Tạo Dataset Repository: Vào profile → "New Dataset"

-

Bắt đầu upload dữ liệu sử dụng các ví dụ trên

Kết Luận

Hugging Face Datasets không chỉ là nơi lưu trữ file - đây là sự thay đổi tư duy về cách quản lý, phiên bản hóa và hợp tác trên dữ liệu. Đối với các nhà phân tích tài chính, đây là công cụ giúp xây dựng hệ thống dữ liệu mạnh mẽ, đáng tin cậy và chuyên nghiệp, để bạn tập trung vào việc quan trọng nhất: tìm kiếm insight từ dữ liệu.

Hãy thử tích hợp vào dự án tiếp theo và cảm nhận sự khác biệt!

Bình luận